2025. 03. 13. - 09:25

Lehengerlő képességekkel állt elő a kis kínai generatív MI-eszköz

Egy kisebb, kínai generatív mesterséges intelligencia-eszköz meglehetősen robusztus képességeket mutat és jóval alacsonyabb költségek mellett működtethető, mint globális versenytársai.

Lenyűgöző képességekkel érkezett meg egy kisebb, kínai, nyílt forráskódú generatív mesterséges intelligencia-modell, amely a mérete ellenére vetekszik a felsőbb szintű globális versenytársakkal – így például a DeepSeek R1-el.

Mindez újabb lépés az MI-alkalmazások teljesítményét és hatékonyságának egyensúlya terén.

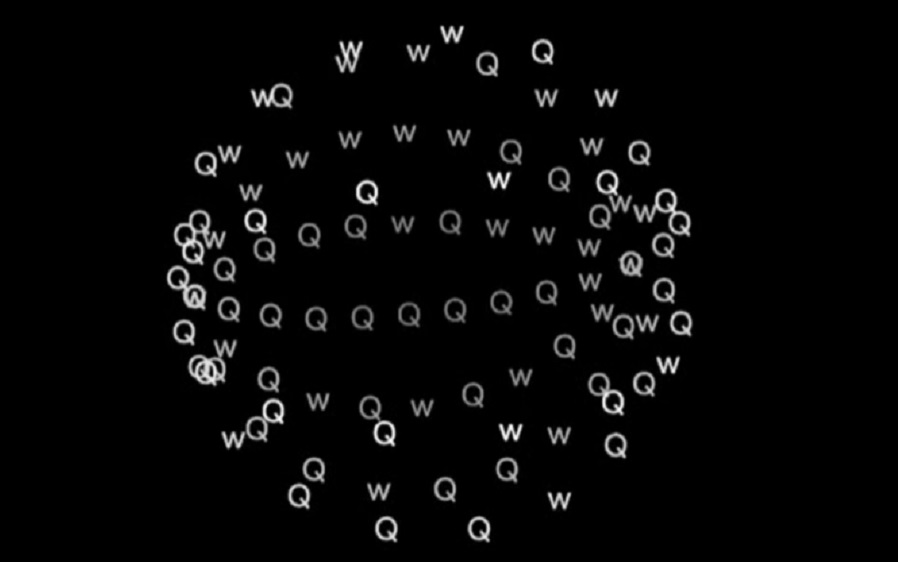

Az új kínai generatív MI-eszköz az Alibaba Qwen csapatának munkája. A QwQ-32B-t március első hetében mutatták be.

Mindössze 24 GB videomemóriával működik, csupán 32 milliárd paraméterrel – miközben a DeepSeek R1 1600 GB-ot igényel a 671 milliárd paraméter futtatásához. Ezzel tehát 98 százalékos csökkenés érhető el.

Mi több, az OpenAI o1-mini-jéhez és az Anthropic Sonnet 3.7-hez képest a Qwen mesterséges intelligencia modellje lényegesen alacsonyabb számítási követelményeket támaszt. Olvasd el: Új elit GMI-klubhoz csatlakozik az Alibaba Cloud

Lehengerlő képességekkel állt elő a kis kínai generatív MI-eszköz

Kyle Corbitt, a Google egykori mérnöke az X közösségimédia-platformon közzétette a teszt eredményeit, amelyek azt mutatják, hogy „a kisebb, nyitott súlyú modell megfelel a legmodernebb érvelési teljesítménynek”.

Corbitt csapata szerint a QwQ-32B a második legmagasabb pontszámot érte el a deduktív érvelési benchmarkban az erősítő tanulás (RL) nevű módszerrel - túlszárnyalva az R1-et, az o1-et és az o3-minit, miközben a Sonnet 3.7 teljesítményével majdnem megegyezik egy következtetéssel, amely több mint 100-szor alacsonyabb volt, mint a szükséges 3 x 7.

„A mesterséges intelligencia nemcsak okosabb lesz, hanem megtanul fejlődni. A QwQ-32B bizonyítja, hogy a megerősítő tanulás felülmúlhatja a nyers erővel végzett skálázást” - kommentálta az eredményeket Shashank Yadav, a Fraction AI vezérigazgatója.

A Qwen blogcikkében a Github-on Yadav arról is beszámolt: kiderült, hogy az RL képzés javítja a teljesítményt, különösen a matematikai és kódolási feladatokban. Bővítése lehetővé teszi, hogy a közepes méretű modellek megfeleljenek a nagy MoE modellek teljesítményének.

A Qwen új modellje várhatóan javítja majd a generatív mesterséges intelligencia-termékek helyi műveleteinek megvalósíthatóságát a jövőben a számítógépeken, sőt a mobileszközökön is.

Awni Hannun, az Apple informatikusa Apple számítógépen futtatta a QwQ-32B-t, amelyet az M4 Max chip hajt. Megjegyezte: jól működik.

Kína nemzeti szuperszámítógépes internetes platformja 2025. március 8-án jelentette be a QwQ-32B API interfész szolgáltatásának elindítását.

Ráadásul a sanghaji székhelyű Biren Technology GPU chiptervező nem sokra rá piacra dobott egy „minden-az-egyben gépet”, amely képes futtatni ezt a modellt.

A QwQ-32B szabadon hozzáférhető, mint nyílt forráskódú modell, amelyet bárki futtathat - követve a DeepSeek útját, amely világszerte elősegíti az MI-technológiák szélesebb körű alkalmazását.

Az Alibaba egyébként a közelmúltban nyílt forráskódúvá tette Wan2.1 AI-videót generáló modelljét is, amely letölthető az Alibaba Cloud AI modellközösségéből, a Model Scope-ból és a Hugging Face együttműködési AI-platformról.

Az e-kereskedelmi és számításifelhő-óriás bejelentette: a következő három évben több mint 380 milliárd jüant fektet be felhő- és mesterséges intelligencia-infrastruktúra kiépítésébe.

B.A.